Ursprünglich veröffentlicht am 15. Dezember 2025.

Verfasst von: Anja Kaup (PR und Marketing Managerin) – anja.kaup@infocient.de

SAP Business Data Cloud (BDC) öffnet die Daten- und Analytics-Welt von SAP erstmals konsequent für starke Technologiepartner – allen voran Databricks. Im dritten InCon-Webinar „SAP Business Data Cloud: Erfolg durch Partnerschaft“ zeigt Constantin Leyh, Cross Product Management SAP BDC&I bei SAP, wie SAP mit OEM-Lösungen und BDC Connect sowohl neue BDC-Kunden als auch bestehende Databricks-, Snowflake- und BigQuery-User adressiert. In einer Demo stellt er am Ende einen durchgängigen HR-Use-Case mit SAP Databricks vor.

BDC-Strategie und Überblick

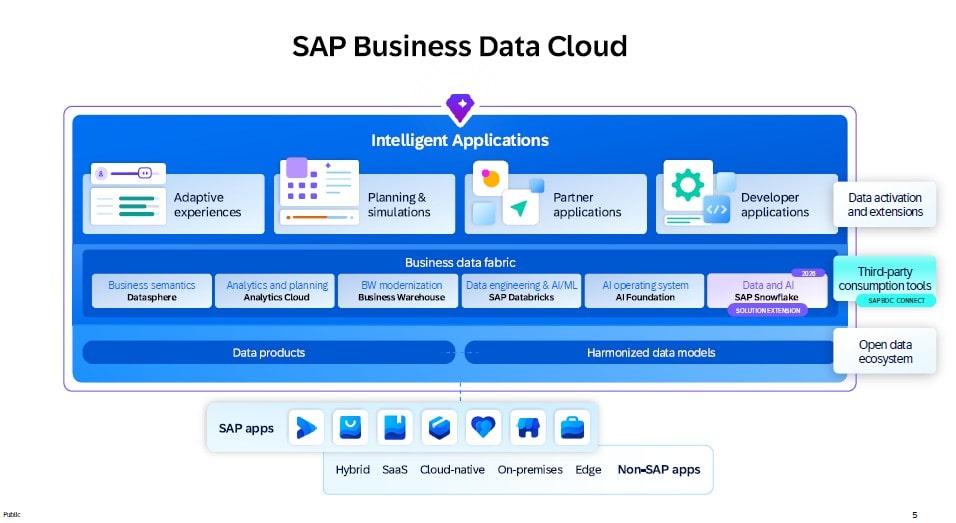

SAP bietet Anwendungssoftware an, die quasi die gesamte Wertschöpfungskette vieler Industrien abdecken kann. Durch die breite Nutzung der eigenen Anwendungen in vielen Branchen entstehen enorme Datenmengen, die bislang in vielen Systemen verteilt sind. Ziel ist es, diese Daten automatisiert zentral nutzbar zu machen, um einheitliches Reporting, neue Applikationen und KI-Szenarien mit zuverlässigen Daten zu ermöglichen, auch über KI.

Dafür wurde die SAP Business Data Cloud als strategische, automatisierte Datenmanagement-Lösung eingeführt, die Daten aus Quellsystemen als standardisierte Datenprodukte bereitstellt und damit aufwendige, selbstgebaute ETL-Prozesse überflüssig machen soll. Gleichzeitig entwickelt SAP auf Basis dieser Datenprodukte „Intelligent Applications“. Diese reichen von einfachen Reports über Planungsanwendungen in SAP Analytics Cloud bis hin zu komplexen Cloud-Apps mit KI-Inhalten und Write-Back-Funktionen für Business-Anwender.

Technisch trennt BDC günstig skalierbare Objektspeicher als Storage-Layer von performanten Compute-Engines wie HANA und Partnertechnologien und stellt Daten als vorkonfigurierte Datenprodukte bereit, statt über aufwendige, kundeneigene ETL-Strecken.

Gleichzeitig öffnet SAP sein Ökosystem weiter:

„Hiermit lizenzieren wir so ziemlich das erste Mal in unserer jungen Geschichte der Cloud-Datenmanagement-Software eine scheinbare Konkurrenzsoftware über unsere Lizenzabkommen.“

Neben klassischen Zugriffswegen über SAP Datasphere und SAP Analytics Cloud kommen nun Partner wie Databricks, Snowflake, Google BigQuery und perspektivisch Microsoft Fabric hinzu, die über Zero-Copy-Mechanismen (BDC Connect Adapter) auf dieselben Business-Datenprodukte zugreifen können. Ziel ist es, Redundanzen zu vermeiden, semantisch konsistente SAP-Daten zentral zu halten und diese orchestriert für Analytics- und KI-Workloads innerhalb und außerhalb der SAP-Welt bereitzustellen.

SAP Databricks ist in der SAP BDC Core-Lizenz enthalten und wird im ersten Halbjahr 2026 allgemein verfügbar sein..

Abb. 1: SAP BDC als zentrale Datenmanagement Plattform, Quelle: SAP SE

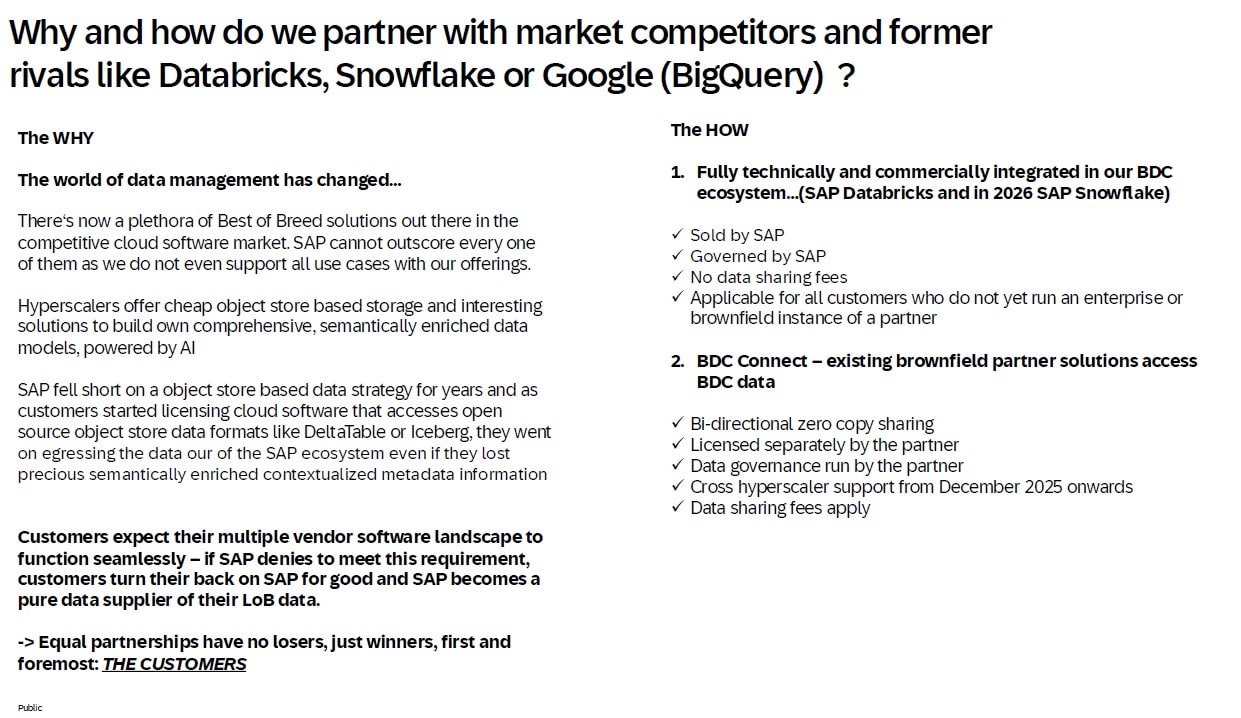

Warum Partnerschaft mit externen Software-Anbietern?

Viele SAP-Kunden haben in den letzten Jahren Databricks, Snowflake oder ähnliche Plattformen als günstige, objektbasierte Datenlayer mit offenen Tabellenformaten wie Delta oder Iceberg etabliert und greifen von dort aus mit Tools wie Power BI oder anderen Frontend-Tools auf SAP-Daten zu.

SAP lief dadurch Gefahr, vom vollwertigen Datenmanagement-Anbieter zum reinen Datenlieferanten zu werden, wenn sich Kunden-Logik und Innovation dauerhaft außerhalb der SAP-Plattform ansiedeln.

Statt gegen diese Landschaft zu arbeiten, setzt SAP daher auf Partnerschaft: SAP BDC soll SAP-Datenprodukte und Governance liefern, während spezialisierte Tools wie Databricks besonders starke Data-Engineering-, Data-Science- und AI/ML-Szenarien adressieren. Durch Zero-Copy-Ansätze über offene Formate werden teure, redundante Datenreplikationen reduziert.

Zwei Varianten der Zusammenarbeit:

SAP bietet bei der Partnerschaft mit Anbietern wie Databricks oder Snowflake zwei Modelle an:.

- In Variante 1 vertreibt und betreibt SAP die Lösung selbst, die Daten bleiben vollständig in der SAP-Umgebung und werden föderiert verarbeitet. Das ist ideal für Kunden, die Databricks oder Snowflake bisher noch nicht nutzen und ohne redundante Kopien von SAP-Daten starten wollen.

- Variante 2 richtet sich an Kunden, die bereits eigene Enterprise-Instanzen von Databricks, Snowflake, Google BigQuery oder Microsoft Fabric im Einsatz haben und diese nun mit Business-Data-Cloud-Datenprodukten verbinden möchten. Hier werden Daten bidirektional und Zero-Copy zwischen BDC und den bestehenden Plattformen geteilt. Für den Datenaustausch über Rechenzentrums- oder Cloud-Grenzen fällt eine vergleichsweise geringe Gebühr an, die deutlich unter den Kosten einer vollständigen physischen Extraktion der SAP-Daten liegt.

Ein im Webinar genanntes Beispiel zeigt, dass reiner Lesezugriff über Delta Sharing massiv günstiger sein kann als das vollständige physische Herausladen von SAP-Daten.

Abb. 2: Gründe für die Partnerschaft mit externen Software-Anbietern, Quelle: SAP SE

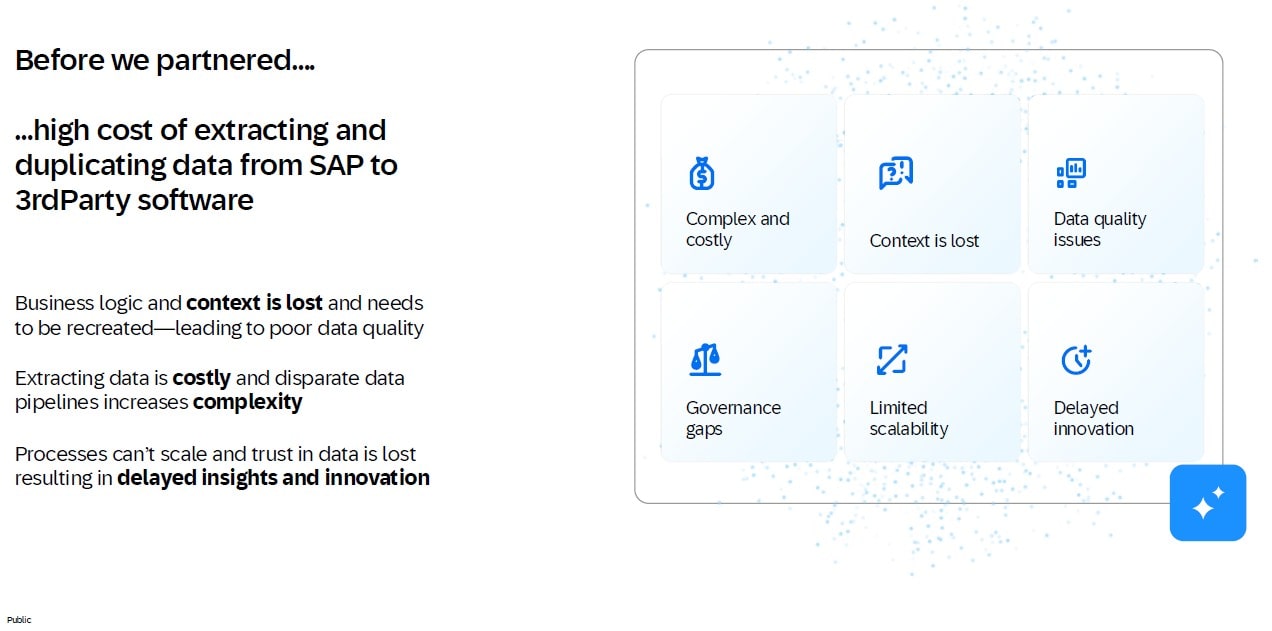

Vor BDC war die Datenextraktion aus SAP technisch und finanziell aufwendig: Man musste rohe ABAP-Tabellen ohne Semantik exportieren und die komplette Logik extern, etwa in Snowflake, neu nachbauen.

Mit BDC stehen zwar semantisch angereicherte Datenprodukte zur Verfügung, für die klassische physische Ausleitung wird aber zusätzlich eine Premium-Outbound-Integration benötigt, die hohe Kosten verursacht. Im numerischen Beispiel zeigt Leyh, dass das reine Lesen von 1 TB über Enterprise Databricks etwa 250 Euro kostet, während das physische Herausladen desselben Datenvolumens aus SAP in einen Object Store rund 8.200 Euro verschlingen würde. Das ist ein recht deutlicher Hinweis, dass sich Zero-Copy-Ansätze wirtschaftlich mehr lohnen.

Abb. 3: Hohe Kosten für die Extraktion und Duplikation von SAP Daten in Drittanbieter-Software, Quelle. SAP SE

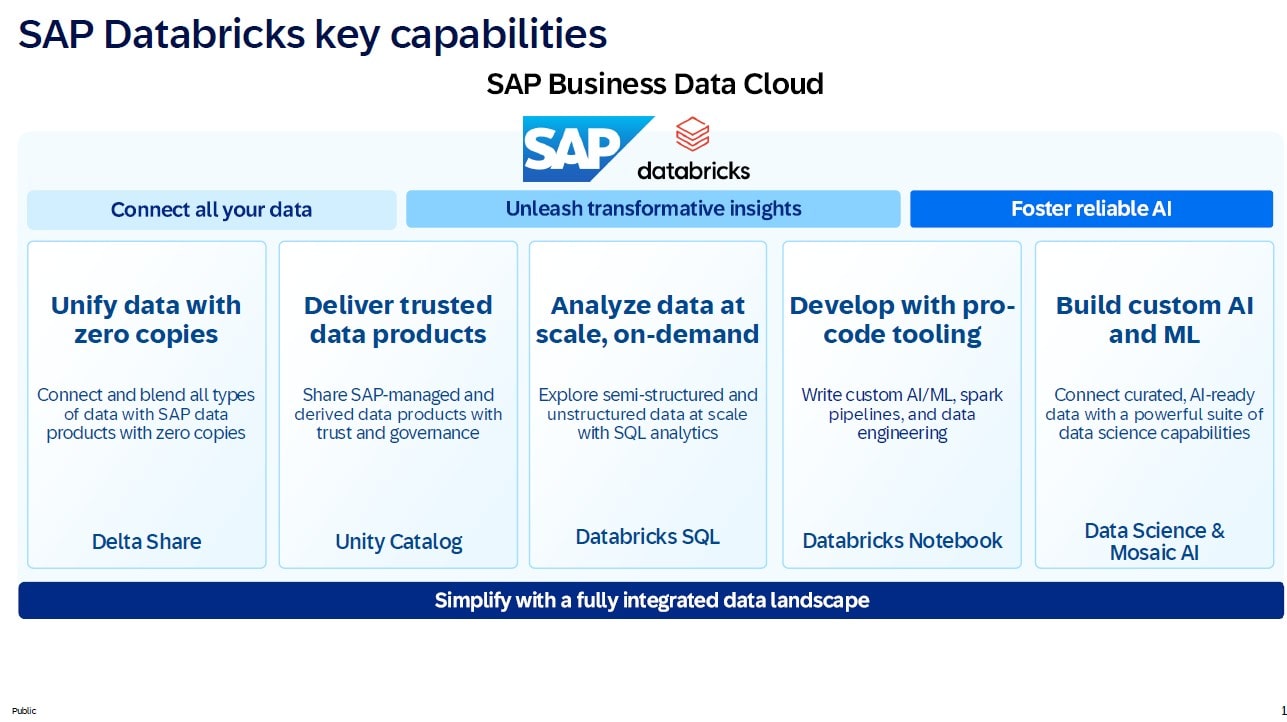

SAP Databricks im Überblick

SAP Databricks ist eine von SAP vollständig gemanagte OEM-Variante der Databricks-Plattform, die direkt in die BDC-Core-Lizenz eingebettet wird – inklusive Zugriff über die BDC-Umgebung und Verbrauch über einheitliche Compute-Units. Kunden können diese Compute-Units flexibel zwischen SAP Analytics Cloud, SAP Datasphere und SAP Databricks aufteilen und erhalten so moderne Notebook-, Python- und SQL-Umgebungen für Data-Science- und AI-Szenarien auf Basis von BDC-Datenprodukten.

Databricks bietet ein starkes Pro-Code-Toolset für Data Scientists und Python-Developer, mit dem sich Daten unterschiedlicher Herkunft flexibel transformieren und mit KI-Verfahren weiter anreichern lassen.

Im Vergleich dazu ist SAP Datasphere eher als No-/Low-Code-Plattform positioniert und bietet nicht die gleiche Tiefe und Performance bei komplexen Transformationen wie Databricks.

Besonders betont wird der AI-Agent von SAP Databricks, der aus natürlicher Sprache ausführbaren Python- oder SQL-Code generiert und damit die Rolle klassischer Entwickler verändert, weil KI immer stärker Programmieraufgaben übernimmt.

Abb. 4: Schlüsselmerkmale von SAP Databricks, Quelle SAP SE

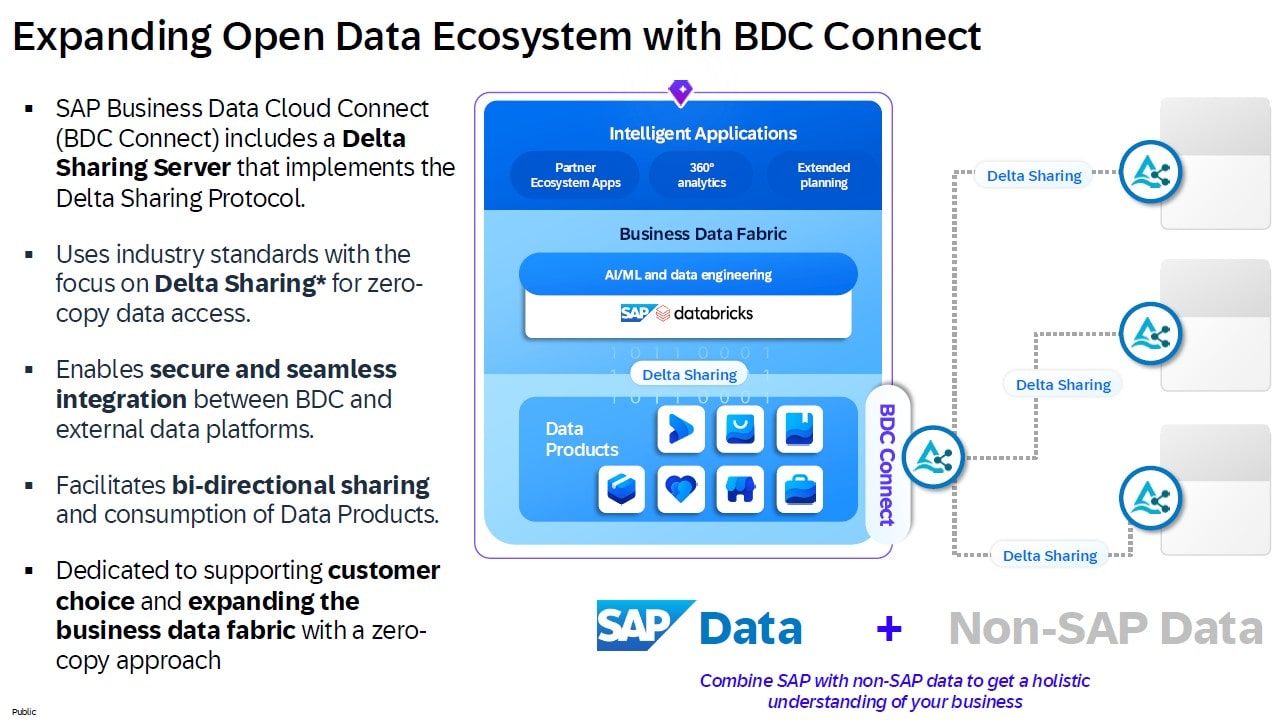

SAP BDC Connect ist das Tor für Partnerlösungen

BDC Connect ist die technische Drehscheibe für die Zero-Copy-Integration zwischen BDC-Datenprodukten und bestehenden Plattformen wie Enterprise Databricks, Snowflake, Google BigQuery und zukünftig Microsoft Fabric.

Unter der Haube setzt SAP auf einen Delta-Sharing-Server und bewährte Sicherheitsmechanismen, um bidirektionalen, fein steuerbaren Zugriff auf SAP-Datenprodukte zu ermöglichen.

Es entstehen zwei zentrale Szenarien:

- „Greenfield“, bei dem Kunden über SAP Databricks oder SAP Snowflake direkt aus der BDC-Core-Welt heraus starten, und

- „Brownfield“, in dem bestehende Enterprise-Instanzen über BDC Connect an die Business Data Cloud angebunden werden. In diesem Szenario fallen im Vergleich zur klassischen physischen Extraktion lediglich relativ geringe Gebühren für den Zero-Copy-Lesezugriff an, während semantische Konsistenz und Governance der SAP-Daten erhalten bleiben.

In der Brownfield-Variante adressiert SAP Kunden, die Databricks, Snowflake, Google BigQuery oder künftig Microsoft Fabric bereits im Einsatz haben und diese mit BDC-Datenprodukten verbinden möchten. BDC Connect stellt dafür eine Partnerschnittstelle bereit, die über einen integrierten Delta-Server Zero-Copy-Delta-Sharing in beide Richtungen ermöglicht und dabei gängige Sicherheitsstandards wie mTLS und OpenID Connect nutzt.

BigQuery und Snowflake werden in diesem Szenario zunächst ausschließlich als Enterprise-Varianten angebunden, also nicht als von SAP vertriebene „Greenfield“-Lösungen; für diese Plattformen ist BDC Connect aktuell der einzige Weg an BDC-Datenprodukte. Gleichzeitig erweitert SAP den Partnerkreis kontinuierlich, sodass neben den bestehenden vier Anbietern perspektivisch weitere hinzukommen können.

Abb. 5: Übersicht über BDC Connect, Quelle: SAP SE

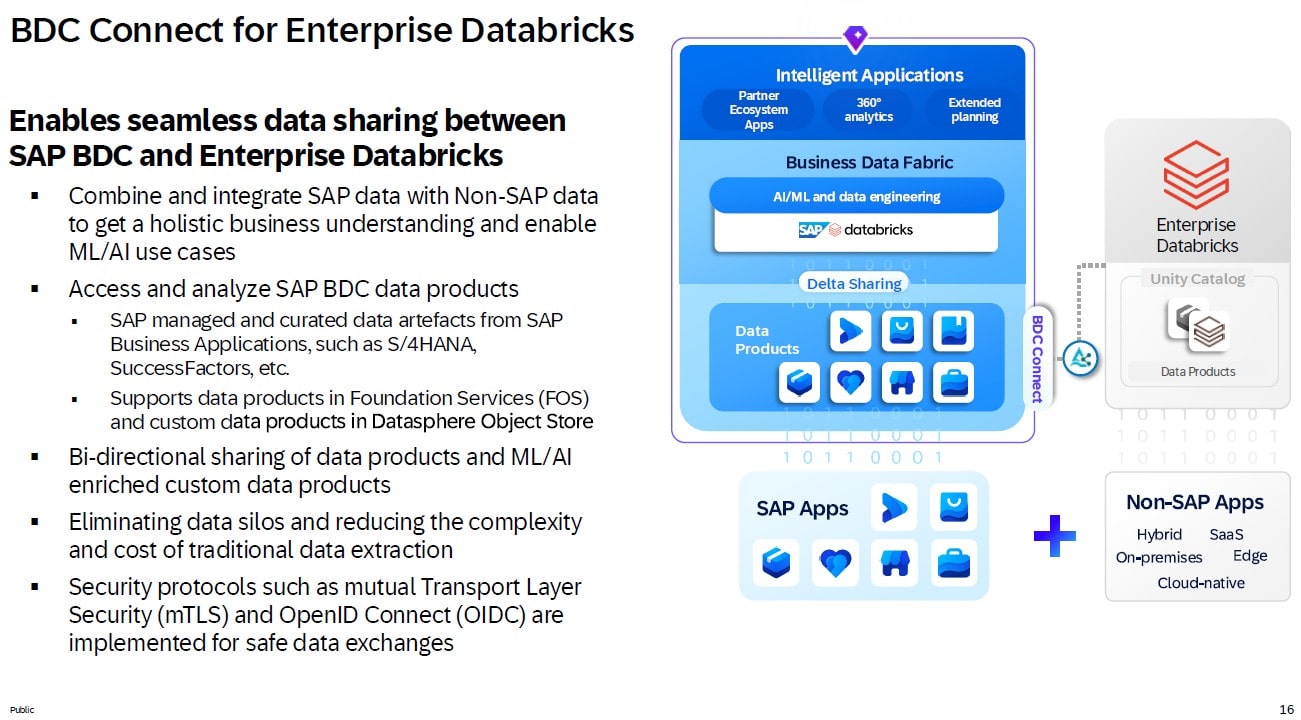

Für Enterprise Databricks stehen prinzipiell dieselben Integrationsmöglichkeiten wie für SAP Databricks zur Verfügung, inklusive Zugriff auf BDC-Datenprodukte. Darüber hinaus bietet Enterprise Databricks jedoch zusätzliche Funktionen, etwa besonders rechenintensive Transformationen auf eigenen Compute-Clustern sowie ein breites Ökosystem an Konnektoren (z. B. für Tableau, Qlik, Power BI, Informatica oder Alteryx), die in der serverlosen OEM-Variante SAP Databricks so nicht verfügbar sind.

Abb. 6: BDC Connect für Enterprise Databricks, Quelle SAP SE

BDC Connect für Snowflake

Für Snowflake verfolgt SAP das Ziel, die eigene OEM-Variante „SAP Snowflake“ funktional möglichst deckungsgleich mit der Enterprise-Version zu gestalten. Snowflake kann – ähnlich wie Databricks – Daten sehr performant verarbeiten und bringt mit Snowconvert AI ein starkes KI-Werkzeug mit, das bestehende Datenmodell-Logik aus Systemen wie Teradata oder Oracle nach Snowflake überführen kann.

Die Anbindung an die SAP Business Data Cloud erfolgt über BDC Connect und ist ab dem 1. Halbjahr 2026 geplant – zunächst dort, wo BDC und Snowflake auf demselben Hyperscaler laufen, beginnend mit AWS-Rechenzentren. Perspektivisch sollen auch Google- und Microsoft-Umgebungen folgen; parallel stehen Databricks-Integrationen über BDC Connect bereits jetzt auf allen großen Hyperscalern zur Verfügung, inklusive Cross-Hyperscaler-Szenarien (z. B. BDC auf AWS, Enterprise Databricks auf Azure).

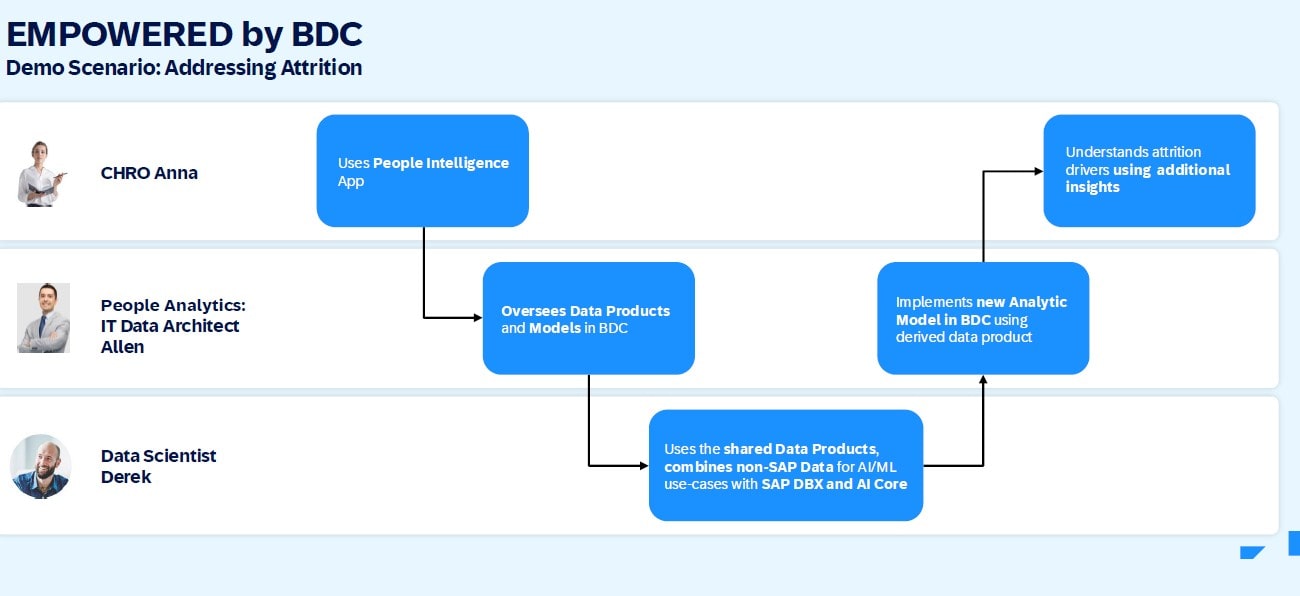

SAP Databricks-Demo eines HR-Use-Case

In der Demo geht es um ein Attrition-Modell. Dies ist ein psychologisches Konzept, das erklärt, wie sich Organisationskulturen entwickeln, indem es den Kreislauf von Anziehung (Attraction), Auswahl (Selection) und Ausscheiden (Attrition) von Mitarbeitern beschreibt.

Im Fallbeispiel nutzt Anna, die HR-Verantwortliche, zunächst eine vorkonfigurierte People-Intelligence-App auf Basis von SAP SuccessFactors-Daten, um Fluktuation und Austrittsgründe in SAP Analytics Cloud zu analysieren. Auffällig hohe Kündigungen in bestimmten Rollen und Zeiträumen führen zur Frage, ob sich mit Hilfe einer kürzlich durchgeführten Mitarbeiterbefragung zukünftige Austritte besser vorhersagen lassen.

Abb. 7: Fallbeispiel für SAP Databricks Demo für ein HR Attrition Use-Case, Quelle: SAP SE

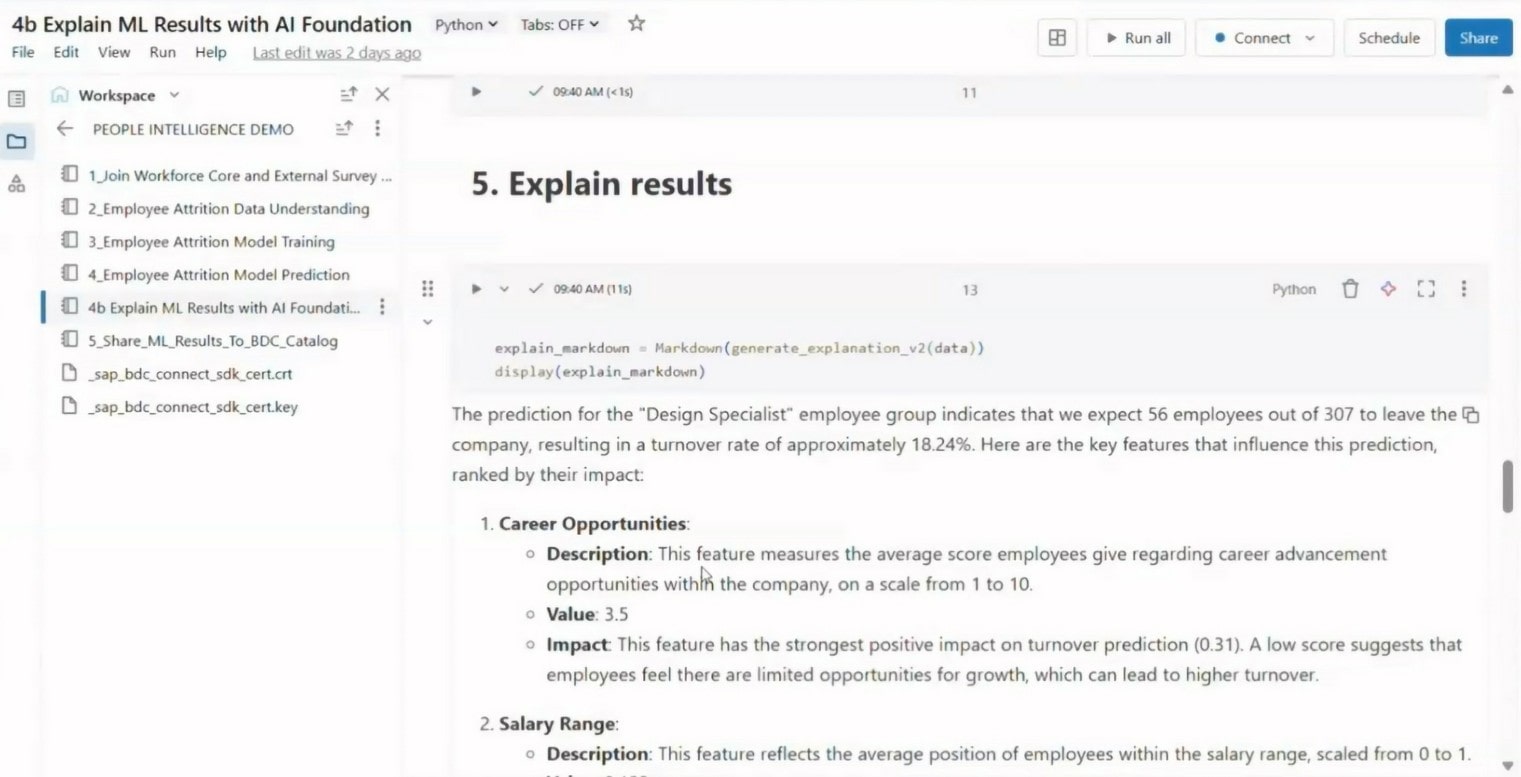

Derek, ein Data Modeler, teilt daraufhin das zugrunde liegende Workforce-Datenprodukt aus BDC via Delta Sharing mit einem SAP-Databricks-Workspace, wo Allen, ein Data Scientist, die Daten mit Umfrageergebnissen (z. B. Zufriedenheit mit Führungskraft, Karrierechancen, Work-Life-Balance) anreichert, anonymisiert und mit Python-Libraries analysiert. Mithilfe von Korrelationsanalysen und einem Klassifikationsmodell werden Einflussfaktoren auf Mitarbeiterfluktuation identifiziert. SHAP-Werte machen transparent, wie stark etwa Rolle, Alter, Firmenzugehörigkeit und wahrgenommene Attraktivität des Arbeitgebers zur Abwanderungswahrscheinlichkeit beitragen. (SHAP-Werte ergeben sich aus der Differenz zwischen dem erwarteten Modelloutput und dem tatsächlichen Output für einen bestimmten Input.)

Das trainierte Attrition-Modell und die abgeleiteten Vorhersagen werden anschließend zurück in den BDC-Katalog publiziert, in SAP Datasphere als zusätzliche Tabellen in ein bestehendes analytisches Modell integriert und schließlich in die HR-App übernommen.

Die HR-Verantwortliche sieht nun direkt in SAC, welche Mitarbeitergruppen mit hoher Wahrscheinlichkeit das Unternehmen verlassen werden und welche Treiber (z. B. Gehalt, Karrierepfad, Angebote am Markt) dominieren – ergänzt durch erklärende Texte aus SAP AI Core.

Abb. 8: Screenshot der Demo, wie die Ergebnisse des Vorhersagemodells mit AI Foundation erklärt werden, Quelle: SAP SE

Fragen und Antworten

- “Wie kann eine Integration zwischen SAP Databricks und Azure Databricks aussehen. Was ist dafür erforderlich?“

Constantin Leyh rät davon ab, SAP Databricks und Azure Databricks parallel zu nutzen, wenn der Kunde Azure Databricks bereits lizenziert hat. Stattdessen sollte besser direkt über BDC Connect auf das beste-hende Azure Databricks zugegriffen werden, um das breitere Feature-Set (z. B. dedizierte Compute-Server, Power BI-Integration) zu nutzen. Technisch wäre ein Sharing zwischen beiden möglich: Ein angereichertes Datenprodukt aus SAP Databricks wird via SDK im BDC-Katalog publiziert, von dort aus über BDC Connect (separat zu lizenzieren) mit Azure Databricks geteilt. Premium-Share-Gebühren fallen jedoch an, weshalb es sich empfiehlt, auf eine Plattform zu fokussieren, idealerweise das vorhandene Azure Databricks.

Fazit

Das Webinar zeigt: SAP Business Data Cloud entwickelt sich zur zentralen Daten- und Orchestrierungsplattform, die semantisch angereicherte SAP-Datenprodukte mit starken Partnerwerkzeugen für Data Engineering und AI verknüpft. Durch OEM-Angebote wie SAP Databricks und die Zero-Copy-Integration über BDC Connect können Unternehmen bestehende Investitionen in Databricks, Snowflake oder BigQuery absichern, ohne auf einheitliche Governance und zentrale Business-Semantik aus der SAP-Welt zu verzichten.

SAP verfolgt mit BDC und den Partnerschaften das Ziel, doppelte und redundante Datenhaltung zu vermeiden und stattdessen eine zentrale Plattform für alle relevanten Daten aufzubauen – sowohl aus SAP-Lösungen als auch aus Fremdsystemen, die bestimmte Use Cases besser abdecken.

Durch die enge Integration dieser Systeme sollen Business-User gemeinsam mit Datenmodellierenden und Data Scientists deutlich mehr Wert aus den Daten ziehen können.

Für Analytics-Teams und Data Scientists eröffnen sich damit neue Spielräume: sie kombinieren vorkonfigurierte SAP-Datenprodukte mit flexiblen, codebasierten Workflows in Databricks und bringen die Ergebnisse nahtlos zurück in SAP Analytics- und Planungsapplikationen. Das ist ein Ansatz, den Infocient Consulting gemeinsam mit Kunden schrittweise in tragfähige End-to-End-Szenarien überführen kann.

Sie benötigen eine individuelle Beratung zu SAP Business Data Cloud? Sprechen Sie mit uns – wir begleiten Sie

- schicken Sie uns eine E-Mail oder

- fragen Sie Dr. Armin Elbert telefonisch: +49 621 596 838-50

Coverfoto von Vitaly Gariev auf Unsplash